Avant de rentrer dans le vif du sujet, il est très important de définir correctement le technofascisme, qui est un mot relativement nouveau. Pour beaucoup, c’est un concept un peu flou, le fascisme lui-même étant naturellement flou (et c’est là toute sa dangerosité).

Qu’est-ce que le technofascisme ?

Le technofascisme désigne l’usage des technologies numériques – entre autres les réseaux sociaux, l’intelligence artificielle et la surveillance de masse – afin de promouvoir, renforcer et faciliter des idéologies plutôt autoritaires et fascisantes.

Il est de bon ton de rappeler également ce qu’est le fascisme, puisque les fascistes eux-mêmes semblent croire que ce sont leurs opposants, les fascistes.

Comment fonctionne le technofascisme ?

Algorithme de propagande : X, Instagram, Facebook, YouTube ou encore TikTok usent de leurs algorithmes pour promouvoir des contenus radicaux – très souvent issus des sphères complotistes et volontairement polarisants – tout en alimentant la désinformation ambiante, qui favorisent naturellement l’engagement via likes, commentaires et partages.

Cyber-radicalisation : Ce qu’on appelle “chambres d’écho” (les fameuses “bulles” dans lesquelles on vit sur internet) permettent aux groupes radicaux, notamment d’extrême droite, de diffuser leur idéologie sans contradiction. Cela facilite la radicalisation des utilisateurs à l’intérieur de ces chambres d’écho. Sans contradicteur, les idéologies basées sur les théories du complot ou la haine ont donc le champ libre.

Mèmes et web culture : L’extrême droite utilise les codes d’internet et l’humour pour diffuser ses idéologies par le biais par exemple de “Pepe the Frog” ou encore “Chad”. L’extrême droite utilise également de nombreux influenceurs réactionnaires pour promouvoir leurs idées et fantasmes. C’est le cas par exemple de Thaïs d’Escufon, égérie de l’extrême droite.

Surveillance de masse : De plus en plus d’états exploitent l’intelligence artificielle pour mettre en place des systèmes de surveillance de masse, souvent sous couvert de sécurité nationale, de lutte contre la criminalité ou même de gestion urbaine. Ces technologies posent de sérieux risques pour les libertés individuelles.

Inversion de la censure : “Liberté d’expression”. Ce terme, utilisé à tort et à travers par l’extrême droite, devient galvaudé. Les réactionnaires crient à la censure dès qu’ils le peuvent mais se permettent en parallèle, via des campagnes de doxxing, de menaces et d’intimidation, de censurer leurs opposants.

Intelligence artificielle : L’IA et les deepfakes jouent un rôle de plus en plus préoccupant dans la manipulation de l’opinion publique, la désinformation et le contrôle autoritaire.

Pour faire simple, le technofascisme est donc le crossover que personne n’attendait et que personne (ou presque) ne veut, entre le fascisme et les technologies numériques.

Dans ce (long) article, on va reprendre chaque technique listée ci-dessus, la détailler, la sourcer et démontrer son application car, vous verrez, les applications de ces techniques sont légions.

Algorithme de propagande

Les réseaux sociaux ont révolutionné la façon dont nous consommons et communiquons l’information en ligne. Mais derrière ce “tout connecté” se cachent des algorithmes avancés, étudiés pour maximiser l’engagement des utilisateurs. Tout ceci se fait de manière absolument transparente pour l’internaute, qui voit son réseau social lui proposer toujours plus de contenus via ce qu’on appelle des “recommandations”.

Ces recommandations poussent très souvent des contenus dits “radicaux”, majoritairement issus de sphères complotistes et volontairement polarisants, uniquement dans le but de faire “du like”.

Uniquement, vraiment ? Pas tout à fait.

L’autre but caché de ces algorithmes, est de manipuler l’opinion en analysant les comportements des utilisateurs. Ils observent les contenus que l’on consomme, les temps de visionnage, nos interactions, nos abonnements… Et via toutes les données collectées, ces algorithmes vous proposent des contenus susceptibles non pas de vous plaire, mais de retenir votre attention. L’idée est d’augmenter le temps passé sur la plateforme.

Une étude interne de Facebook a révélé que ses algorithmes amplifiaient les publications dites “sensationnalistes”, y compris celles qui incitent à la haine ou véhiculant des discours de haine. [1] [2]

On parle ici d’algorithme. On pourrait simplement se dire que “c’est aléatoire” et que personne ne s’amuse à “hacker” cet algorithme pour pousser des contenus violents. C’est évidemment faux.

Sur TikTok, des documents prouvent que des groupes néonazis s’amusent à exploiter l’algorithme de recommandation en créant des réseaux de comptes interconnectés, augmentant ainsi la visibilité des contenus aux idéologies violentes. [3] [4]

Cyber-radicalisation

Autre conséquence des manipulations par les algorithmes de recommandation : la radicalisation par “effet-bulle” ou chambre d’écho. [5]

Si vous êtes intéressés par les chats, il est évident que vous allez voir plus de contenus liés aux chats qu’aux chiens. Tout comme vous allez voir plus de contenu liés aux animaux qu’au bricolage.

Il en va de même avec des sujets plus clivants. En s’exposant à des contenus conformes à nos croyances et intérêts personnels et en étant de moins en moins exposés à des perspectives divergentes, on favorise notre radicalisation. On appelle ce phénomène le “biais de confirmation”.

Avec l’amplification de contenus toujours plus radicaux et complotistes, on observe des répercussions tangibles au sein de notre société. La diffusion de fausses informations entraîne d’une part, une méfiance accrue vis-à-vis d’institutions et plus généralement de la science et d’autre part, une polarisation du débat public.

Une étude de Jonathan Bright, éminent chercheur britannique du Alan Turing Institute, et spécialisé dans l’intelligence artificielle, analyse les discussions en ligne de 90 partis politiques issus de 23 pays différents et révèle que les groupes situés aux extrémités du spectre politique interagissent moins avec les personnes ayant des perspectives opposées, favorisant cette notion de “chambre d’écho”. [6]

Comme évoqué précédemment, l’extrême droite a su tirer parti de ces mécanismes pour diffuser leurs idéologies. Le Royaume-Uni en a fait les frais récemment, via des personnalités publiques comme Tommy Robinson, militant politique d’extrême droite, qui a mobilisé de nombreux sympathisants autour de discours islamophobes et xénophobes générant des émeutes dans tout le pays suite au décès de trois enfants.

Ces chambres d’écho facilitent la diffusion de théories du complot et les discours haineux. On y retrouve de simples moqueries pouvant s’apparenter à des comportements “enfantins” comme des photomontages, des parodies ou encore des captures d’écran avec un texte moqueur tout comme des appels au meurtre.

En étant continuellement exposés à des informations abondant dans leur sens, les utilisateurs deviennent plus enclins à accepter les discours conspirationnistes et les comportements hostiles envers des personnes ou groupes cibles.

Mèmes et web culture

Que serait internet sans les mèmes ? Ces contenus sous forme d’image, de vidéo ou de texte, de nature bien souvent humoristique ou sarcastique sont monnaie courante sur la toile. Et ça, l’extrême droite l’a bien compris. Elle a su s’approprier ces nouveaux codes pour diffuser de manière subtile par le biais de l’humour – je me passerai de commenter cet “humour” – ses idéologies.

Le premier mème très populaire qui a été “absorbé” par l’extrême droite est probablement “Pepe the Frog”, un personnage de BD créé par Matt Furie, qui n’avait absolument aucune connotation raciste ou antisémite.

On observe pourtant depuis 2015, un détournement de ce mème pour le placer dans des contextes liés au nazisme, au Ku Klux Klan ou encore à la suprématie blanche. Dès 2016, il s’invite dans la campagne de Trump [8] qui, qu’on soit d’accord ou pas avec lui, opte pour une politique très agressive, réactionnaire, aux idées bien “de droite”. (Censure de mots, climatoscepticisme, LGBTphobie, anti-féminisme à outrance, etc.)

Un autre mème très populaire et détourné de son usage initial est “Chad”, cet homme blond et barbu, de profil (un archétype masculin idéalisé) qu’on oppose très souvent au “Virgin”. “Chad” est régulièrement utilisé pour véhiculer des stéréotypes de genre et des idéologies réactionnaires. [9]

On peut également citer “Mask Wojak”, fièrement renommé “Soyjak” (en rapport avec les soyboy, ces soi-disant “hommes-soja”, ou “hommes-faibles” car soutenant par exemple des causes féministes), pour moquer les idées progressistes dites “woke”.

Surveillance de masse

Concernant la surveillance de masse, il existe de très nombreux exemples d’applications.

La Chine utilise depuis longtemps la reconnaissance faciale et la surveillance extrême de sa population (jusqu’aux caissières qui doivent sourire). En outre, c’est notamment la population des Ouïghours qui est visée, déjà oppressée depuis des décennies. [10]

Aux USA et au Royaume-Uni, la reconnaissance faciale est utilisée pour empêcher les personnes suspectées de vols d’entrer dans des magasins. [11]

Le Danemark lutte contre la fraude sociale avec l’aide d’un système de surveillance de masse dopé à l’intelligence artificielle. Ce système analyse les déplacements, les relations familiales, les antécédents de santé et les liens avec des pays étrangers des allocataires afin de déceler une potentielle fraude. [12]

Les conséquences sont, en vrac : la disparition, à terme, des libertés et du droit à la vie privée, le renforcement des régimes totalitaires, une normalisation de la surveillance et du principe de contrôle et donc, in fine, un très grand risque pour nos démocraties.

Pour vous le prouver, des pays – certes pas très démocratiques mais quand même – commencent à utiliser la surveillance pour traquer toute opposition au pouvoir en place :

- En Chine, un système de points récompense ou punit les citoyens en fonction de leur comportement. (payer ses factures à temps, éviter les critiques contre le Parti, etc.) [13]

- La Russie et l’Iran utilisent la reconnaissance faciale pour identifier et traquer les activistes. En Iran, par exemple, après la révolte de 2022 contre le port du voile obligatoire, des caméras IA ont été déployées pour repérer les femmes ne portant pas correctement leur hijab. [14]

Les pays réputés plus démocratiques, comme la France, ne sont pas en reste non plus. Comme le souligne Amnesty International, dès 2019 à Nice, la surveillance de masse via reconnaissance faciale a été testée lors de son carnaval via un logiciel israëlien, “briefvision”. [15]

On notera que Marseille et Nice ont souhaité (en vain) équiper certains lycées de reconnaissance faciale pour filtrer les entrées en 2018.

La police française s’est équipée d’un logiciel de reconnaissance faciale – là encore d’origine israélienne – appelé “briefcam”, entre 2015 et 2024. L’affaire a été révélée par une enquête de Disclose en 2023. [16]

C’est lors des JO de Paris 2024 que la vidéosurveillance de masse assistée par l’IA s’est déployée à une plus large échelle. Amnesty International a, là aussi, dénoncé ces pratiques, à l’encontre des directives européennes. [17] [18]

L’ONG a recensé de nombreux cas, des gares de Paris à Valenciennes en passant par le stade de Metz.

Inversion de la censure

Parlons maintenant d’un sujet prépondérant : la victimisation de l’extrême droite et la manipulation de “la liberté d’expression” engendrant ce qu’on appelle une “censure inversée”.

Le principe repose sur une stratégie à deux vitesses :

- Se poser en victime de la censure et dénoncer une supposée “dictature” liée à un certain “wokisme” et une “bien-pensance”, qui empêcherait de diffuser leurs idées. Pour rappel : lorsqu’il y a censure de propos racistes ou lgbtphobes, on ne fait qu’appliquer la loi.

- Harceler, intimider, menacer et diffuser des informations privées (doxxing) pour faire taire les critiques (qui censure qui ? 🙂 )

Concrètement, cette censure inversée transforme la liberté d’expression en un outil politique à sens unique, où l’extrême droite revendique le droit de tout dire, tout en empêchant les autres de s’exprimer librement.

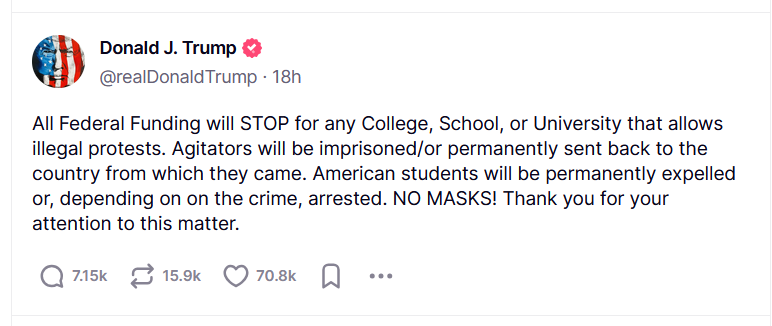

« Les agitateurs seront emprisonnés et/ou renvoyés définitivement dans leur pays d’origine », ajoute-t-il, tandis que « les étudiants américains seront définitivement exclus ou, selon leur crime, arrêtés. PAS DE MASQUES », écrit-il.

Mais approfondissons le sujet en analysant cette stratégie.

Victimisation et instrumentalisation de la liberté d’expression

En se positionnant comme un groupe persécuté, l’extrême droite et les fascistes d’une manière générale souhaitent dénoncer une pseudo censure imposée.

L’exemple le plus frappant de ces dernières années a été le rachat de Twitter (devenu X) par Elon Musk (qui est aujourd’hui au gouvernement de Donald Trump) pour réintégrer de nombreux comptes d’extrême droite et conspirationnistes, sous couvert de défendre la liberté d’expression. [19]

Harcèlement et intimidation de l’opposition

Le doxxing (la diffusion d’informations personnelles pour l’exposer au harcèlement) est l’arme la plus fréquemment utilisée par l’extrême droite contre les journalistes, les chercheurs, les militants ou encore les personnalités publiques. De nombreux exemples existent. On peut notamment citer le scandale de juillet 2024, où un site d’extrême droite a publié les adresses de femmes et d’hommes politiques de gauche mais aussi d’avocats et de journalistes, dont Salomé Saqué. Le message est clair : les faire taire “d’une balle dans la nuque”. [20]

Depuis très longtemps, ces personnalités subissent le cyber-harcèlement, dopé au laxisme des journaux en ligne et des réseaux sociaux, dont l’espace commentaire ne connaît visiblement pas le mot “modération”.

La journaliste Julia Montfort, depuis 2019, subit des vagues de haine à chaque prise de parole publique, suite à la sortie de son documentaire “Carnets de solidarité”. [21]

Le harcèlement est d’autant plus violent vis-à-vis des femmes qui reçoivent des appels au viol et au meurtre régulièrement.

Citation : Depuis le début de la période électorale, les menaces contre les journalistes et le droit à l’information se sont sérieusement intensifiées.

- Pavol Szalai, responsable Europe de l’organisation Reporters sans frontières.

Campagnes de harcèlement organisées

Des groupes d’extrême droite s’organisent sur les réseaux sociaux et les applications pour préparer leurs assauts, à coup de raids numériques, de signalements abusifs et de manipulation des algorithmes, via notamment des bots.

La journaliste du site Arrêtsurimages.net, Nassira El Moaddem, est visée par une campagne de haine initiée par un député du Rassemblement National, Julien Odoul, depuis qu’elle a qualifié la France de « pays de racistes dégénérés » sur les réseaux sociaux. [22]

La journaliste de Le Monde, Ivanne Trippenbach, est victime d’une campagne de cyberharcèlement d’extrême droite, cible de messages racistes et antisémites. Le RN l’accuse d’avoir pénétré dans une église lors des funérailles de Jean-Marie Le Pen, accusation démentie par sa rédaction. Malgré cela, elle subit un flot de haine en ligne, encouragé par le député Alexandre Allegret-Pilot, qui a multiplié les publications incitant à son lynchage. [23] (screenshot du tweet)

Depuis plusieurs années, on observe une hausse flagrante des violences issues de l’extrême droite. Ces groupes ultra violents ont récemment fait annuler, à coup de menaces et d’actions violentes, la création d’un centre d’accueil de migrants, un concert, des sorties scolaires et des spectacles pour enfants. Des figures de Reconquête! et du Rassemblement National sont liées à certaines de ces actions. [24]

Violences physiques

La violence physique est une pratique courante pour l’extrême droite.

En février 2025, six militants d’extrême droite ont été mis en examen après avoir attaqué les locaux d’une association culturelle turque à Paris, blessant plusieurs personnes. [25]

On observe également une hausse des violences LGBTphobes. En effet, des groupuscules néofascistes s’en prennent régulièrement à des militants antiracistes ou LGBTQIA+, recourant à la violence physique pour imposer leurs idées et intimider leurs opposants. Le média Basta! liste régulièrement des actes de violence émanant de l’extrême droite. [26]

On peut également souligner la publication de Papacito, un youtubeur identitaire, d’une vidéo mettant en scène une attaque armée fictive contre un électeur de La France insoumise. [27]

Manipulation des réseaux sociaux

Qui ne s’est pas déjà fait censurer un post, un commentaire ou même un compte, après une vague de signalement de l’extrême droite ?

C’est en effet une technique courante de la part de ces militants ultra violents, qui exploitent les politiques anti-harcèlement des plateformes pour faire suspendre les comptes de leurs opposants, via des campagnes de signalement abusif. [28]

Comme évoqué précédemment, concernant la propagande et les “chambres d’écho”, on peut souligner l’usage des réseaux sociaux par l’extrême droite pour manipuler les populations en promouvant des fake news pour diffuser leurs messages. [29]

Intelligence artificielle

En France, de fausses influenceuses, issues de la famille Le Pen (Amandine Le Pen et Léna Maréchal), ont fait leur apparition sur TikTok. [30]

Avec plus de 30 000 abonnés chacune (les comptes ont été supprimés depuis), ces deux influenceuses virtuelles rendaient l’extrême droite “cool” en reprenant les codes qui ont fait le succès de ce réseau social : musiques tendances, chorégraphies, langage “internet”,etc.

L’objectif ? Rendre le Rassemblement National “sexy” et glamour, mais aussi plus proche du citoyen lambda. Et à lire les commentaires sous les vidéos, les jeunes utilisateurs de ce réseau social sont tombés dans le panneau plus d’une fois. Tout comme X, TikTok est un terreau fertile au complotisme et à la désinformation auprès de la jeunesse. [31]

Lors des élections européennes de 2019, l’Institute for Strategic Dialogue (ISD) a identifié plusieurs campagnes de harcèlement en ligne visant des figures publiques en Espagne, France et Italie. Ces campagnes étaient menées par une combinaison de comptes individuels, de trolls et de bots boostés à l’IA et affiliés à des partis d’extrême droite, cherchant à intimider et discréditer leurs opposants. [32]

Le projet COMPROP, financé par le Conseil européen de la recherche, a étudié comment des réseaux de comptes automatisés, ou « bots », sont utilisés pour influencer l’opinion publique en Europe. Ces bots diffusent massivement du contenu politique, amplifiant artificiellement certaines voix, notamment celles de l’extrême droite, et contribuant à polariser le débat public. [33]

On peut noter – et ce serait assez cocasse si ce n’était pas dramatique – que Google a retiré de sa charte éthique la clause stipulant que l’IA ne devait pas être utilisée pour fabriquer des armes et faire de la surveillance. La raison ? L’accélération des usages de l’intelligence artificielle à des fins militaires et l’alignement avec le gouvernement fasciste de Donald Trump. [34]

Une hausse inédite de ces violences, toujours perpétrées par l’extrême droite, et facilitée par les réseaux sociaux

L’augmentation des violences envers les journalistes, politiques, scientifiques ou encore militants n’est pas anodine. Le but affiché n’est pas forcément de violenter physiquement, mais de forcer à l’auto-censure les médias et militants sur de nombreux sujets épineux.

Citation : Ce cyberharcèlement est dirigé vers des journalistes qui enquêtent sur l’extrême droite, qui traitent de problématiques climatiques ou migratoires…

- Pavol Szalai, responsable Europe de l’organisation Reporters sans frontières.

Ces attaques prennent plusieurs formes :

- Le doxxing (publication d’informations personnelles de la cible)

- Les menaces directes (meurtre, viol, etc.)

- La diffamation et les campagnes de désinformation

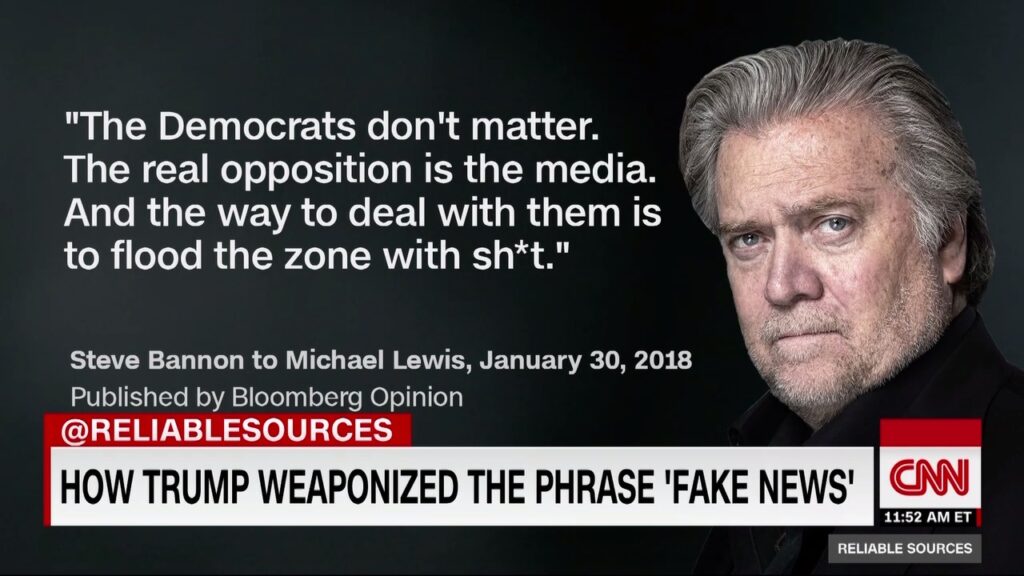

- L’inondation de contenus haineux, dans la foulée de la mise en oeuvre de la stratégie de Steve Bannon : “Flood the zone with shit” (Innonder la zone de merde). Steve Bannon qui vient tout juste de faire un salut nazi [35], lui-même dans la foulée de celui d’Elon Musk [36], l’homme le plus riche du monde et fraichement entré au gouvernement de Donald Trump.

Et tout ça avec la complicité des réseaux sociaux, qui banalisent la violence en ligne.

Le mot de la fin

Maintenant, vous savez tout. Vous savez comment ils fonctionnent. Vous connaissez leurs techniques.

Alors, on fait quoi ?

Déjà, on reste vigilants. Le fascisme n’est pas un parti politique ni une idéologie. Le fascisme est insidieux et, quand il est en place, il est difficile de l’éradiquer.

Dopé aux nouvelles technologies, le fascisme fait feu de tout bois pour imposer ses idées nauséabondes.

Ensuite, on s’informe. On s’éduque. On s’éveille. On aiguise son esprit critique. On ne prend pas toute information pour argent comptant. On se documente, on lit, on vérifie les sources. À l’heure des IA génératives qui peuvent facilement nous berner, on reste sur nos gardes. [37]

Enfin, on soutient de TOUTES LES FAÇONS POSSIBLES les médias indépendants. On like, on commente, on partage. Et si on le peut, on soutient financièrement ces médias qui généralement ont peu de revenus mais font un travail salutaire.

À l’heure où la plus grande puissance du monde supprime de ses instances officielles plus de 120 mots dont “femme”, “climat” ou encore “inclusion” face au “péril woke”, il est URGENT de faire front commun face au fascisme. [38]

Sources et références

[1] Franceinfo : « Facebook Files » : ce qu’il faut retenir des révélations de la lanceuse d’alerte Frances Haugen

[2] Wall Street Journal (en) : The Facebook files

[3] Le Monde : « NazTok » : un rapport révèle comment des groupes néonazis utilisent l’algorithme de TikTok à leur avantage

[4] Institute for Strategic Dialogue (en) : NazTok – An organized neo-Nazi TikTok network is getting millions of views

[5] Cogitatio (en) : Conspiracy Beliefs, Misinformation, Social Media Platforms, and Protest Participation

[6] Cornell University (en) : Explaining the emergence of echo chambers on social media: the role of ideology and extremism

[7] Le Monde : Au Royaume-Uni, une extrême droite éclatée mais capable de fortement mobiliser

[8] Slate (en) : The Far Right’s New Toad Mascot Is a Fatter, More Racist Pepe the Frog

[9] Le Monde : Comment l’extrême droite s’est appropriée la culture mème

[10] Reuters : Un logiciel de reconnaissance faciale d’Alibaba cible les Ouïghours en Chine

[11] RTS : La reconnaissance faciale contre les vols à l’étalage en Angleterre

[12] Amnesty International : Danemark/UE. Le système de protection sociale assisté par IA alimente la surveillance de masse et risque d’entraîner une discrimination des groupes marginalisés

[13] Le Monde : En Chine, le « crédit social » des citoyens fait passer les devoirs avant les droits

[14] Amnesty International (en) : Iran: Draconian campaign to enforce compulsory veiling laws through surveillance and mass car confiscations

[15] Amnesty International : Face à l’ampleur des technologies de surveillance en France

[16] Disclose : Reconnaissance faciale : la police désactive le logiciel Briefcam après l’enquête de Disclose

[17] Amnesty International : France. Les technologies intrusives de surveillance lors des Jeux olympiques pourraient inaugurer un avenir dystopique

[18] Amnesty International : France. L’autorisation de la surveillance de masse lors des Jeux olympiques nuit au travail de l’UE en vue de réglementer l’intelligence artificielle

[19] Le Monde : Complotistes, homophobes, néonazis… Dix comptes emblématiques de la dérive de Twitter sous Elon Musk

[20] France 3 régions : « Ils cherchent à éliminer leurs opposants » : un site d’extrême-droite appelle au meurtre d’élus franciliens de gauche

[21] INA : Cyberharcèlement d’une journaliste : « Je ne m’attendais pas à ces assauts ultra-organisés »

[22] Franceinfo : La journaliste Nassira El Moaddem harcelée par l’extrême droite sur les réseaux sociaux

[23] Blast : Un député d’extrême droite encourage le harcèlement d’une journaliste

[24] Basta! : Intimidations, harcèlement : les campagnes racistes et homophobes de l’extrême droite se multiplient

[25] 20 minutes : Paris : Six militants d’extrême droite mis en examen après l’attaque des locaux d’une association culturelle turque

[26] Basta! : Violences d’extrême droite

[27] Le Monde : Jean-Luc Mélenchon annonce le dépôt d’une plainte après la diffusion d’une vidéo simulant le meurtre d’un électeur de LFI

[28] Le Monde : Twitter reconnaît des « erreurs » dans sa nouvelle politique de lutte contre le harcèlement, détournée par l’extrême droite américaine

[29] Le Monde : « Les réseaux sociaux sont une arme politique de destruction massive »

[30] La Dépêche : « Amandine Le Pen » et « Léna Maréchal » : qui sont ces influenceuses virtuelles qui font la promotion de l’extrême droite sur TikTok ?

[31] Observatoire du numérique : Internet et théories du complot (2/2)

[32] Basta! : Bots et manipulations : comment le Kremlin tente d’influencer les élections en faveur du RN

[33] Commission européenne (en) : Des armées secrètes de robots sapent la démocratie

[34] Le Monde : Google assouplit ses principes concernant l’usage de l’IA dans l’armement ou la surveillance

[35] Franceinfo : Après un salut nazi de Steve Bannon, Jordan Bardella annule sa participation à un rassemblement d’extrême droite aux Etats-Unis

[36] Franceinfo : Salut nazi d’Elon Musk : que se cache-t-il derrière cette séquence qui a fait le tour du monde ?

[37] Microsoft (en) : The Impact of Generative AI on Critical Thinking: Self-Reported Reductions in Cognitive Effort and Confidence Effects From a Survey of Knowledge Workers

[38] Médiapart : La « Grande Suppression »